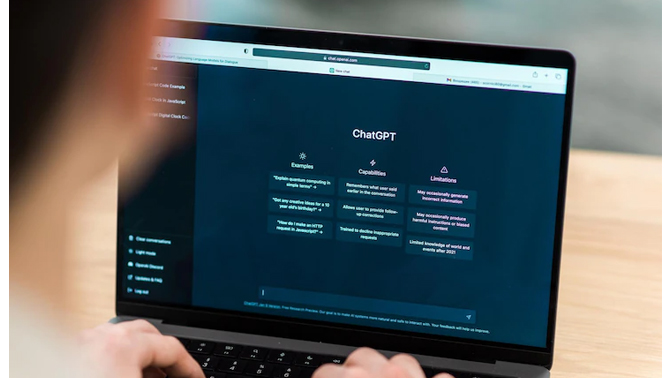

ChatGPT es la herramienta más citada en los incidentes vinculados a la IA

- Seguridad

La base de datos AI Incident Database registró 346 incidentes relacionados con inteligencia artificial en 2025, desde fraudes con deepfakes hasta casos de contenido peligroso generado por chatbots. Los expertos alertan de que la popularidad de un modelo no garantiza su seguridad.

El uso masivo de herramientas de inteligencia artificial durante 2025 vino acompañado de un aumento significativo de incidentes relacionados con su uso indebido o fallos de seguridad. Según un análisis de Cybernews basado en la AI Incident Database, el año cerró con 346 casos documentados, que abarcan desde fraudes impulsados por deepfakes hasta situaciones con consecuencias graves para la seguridad personal.

Los deepfakes fueron el tipo de incidente más frecuente, con 179 casos, muchos de ellos vinculados a estafas financieras y suplantación de identidad. También se registraron 37 incidentes de contenido violento o inseguro, algunos con consecuencias fatales, como casos en los que chatbots ofrecieron consejos peligrosos a usuarios en situaciones de vulnerabilidad.

35 incidentes se vinculan a ChatGPT

Aunque la mayoría de los casos no mencionan una herramienta concreta, entre los que sí lo hacen ChatGPT aparece en 35 incidentes, convirtiéndose en el modelo más citado en 2025.

Los incidentes asociados a ChatGPT abarcan desde violaciones de copyright, como un caso en un tribunal alemán; problemas de salud mental, con interacciones que derivaron en situaciones de riesgo; y generación de contenido inseguro, cuando los usuarios lograron sortear las barreras de seguridad del modelo.

Tras ChatGPT, las herramientas Grok, Claude y Gemini aparecen empatadas con 11 casos cada una, aunque los investigadores advierten de que la cifra real podría ser mayor, ya que muchos incidentes no especifican el modelo implicado.

El análisis subraya que la reputación o el uso masivo de una herramienta no garantizan su seguridad. Incluso los modelos más avanzados dependen de sistemas de protección que pueden fallar, especialmente cuando los usuarios intentan deliberadamente eludirlos.

Investigaciones de Cybernews demuestran que los grandes modelos de lenguaje pueden ser inducidos a generar contenido peligroso si se formulan los prompts adecuados, lo que evidencia la necesidad de reforzar los controles y mejorar la supervisión humana.

Los expertos coinciden en que el crecimiento de los incidentes refleja un desafío que seguirá intensificándose. La combinación de deepfakes cada vez más realistas, chatbots más influyentes en la vida cotidiana y usuarios capaces de manipular los sistemas exige nuevas medidas de seguridad, mayor transparencia y una regulación más sólida.