Dynatrace amplía el valor de su plataforma con la incorporación de OpenPipeline

- Actualidad

Esta nueva tecnología permite el control total de los datos en el momento de la ingesta y evalúa los flujos de datos entre cinco y diez veces más rápido que las tecnologías heredadas, lo que ayuda a aumentar la seguridad, facilitar la gestión y maximizar el valor de los datos, permitiendo la toma de decisiones mejor informada.

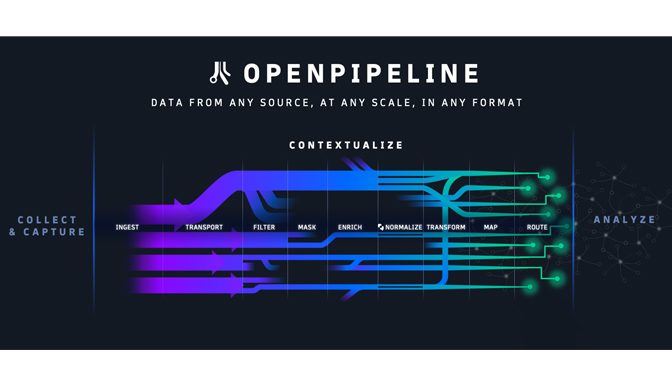

Dynatrace ha anunciado el lanzamiento de OpenPipeline, una nueva tecnología central que proporciona a los clientes un único pipeline para gestionar la ingesta de datos a escala de petabytes en la plataforma Dynatrace.

Dynatrace OpenPipeline ofrece a los equipos de negocio, desarrollo, seguridad y operaciones una visibilidad y un control totales de los datos que están ingiriendo en la plataforma Dynatrace, al tiempo que preserva el contexto de los datos y los ecosistemas cloud en los que se originan. Además, evalúa los flujos de datos entre cinco y diez veces más rápido que las tecnologías heredadas. Como resultado, las organizaciones pueden gestionar mejor el creciente volumen y variedad de datos que emanan de sus entornos híbridos y multicloud y permite a más equipos acceder a las respuestas y automatizaciones impulsadas por IA de la plataforma Dynatrace sin necesidad de hacer uso de herramientas adicionales.

"OpenPipeline es una potente incorporación a la plataforma Dynatrace", afirma Bernd Greifeneder, CTO de Dynatrace. "Enriquece, converge y contextualiza datos heterogéneos de observabilidad, seguridad y negocio, proporcionando análisis unificados para estos datos y los servicios que representan."

Un pipeline unificado para gestionar los datos

Según Gartner, las cargas de trabajo actuales generan cientos de terabytes e incluso petabytes de datos cada día de telemetría procedente de diversas fuentes. Crear un pipeline unificado para gestionar estos datos es todo un reto debido a la complejidad de las arquitecturas de cloud modernas. Esta dificultad, y la proliferación de herramientas de supervisión y análisis en las organizaciones, pueden sobrecargar los presupuestos. Al mismo tiempo, las compañías necesitan cumplir con una serie de normas de seguridad y privacidad, como GDPR e HIPAA, en relación con sus pipelines de datos, análisis y automatizaciones. Dynatrace OpenPipeline trabaja con otras tecnologías de la plataforma Dynatrace, incluyendo el Grail data lakehouse, la topología Smartscape, y Davis hypermodal AI, para hacer frente a estos desafíos mediante la entrega de los siguientes beneficios:

- Análisis de datos a escala de petabytes: Aprovecha los algoritmos de procesamiento de flujos pendientes de patente para lograr rendimientos de datos a escala de petabytes.

- Ingesta de datos unificada: Permite a los equipos ingerir y mejorar el enrutamiento de datos de observabilidad, seguridad y eventos de negocio desde cualquier fuente y en cualquier formato, como Dynatrace OneAgent, APIs de Dynatrace y OpenTelemetry, con tiempos de retención personalizables para casos de uso individuales.

- Análisis de datos en tiempo real en la ingesta: Permite a los equipos convertir datos no estructurados en formatos estructurados y utilizables en el punto de ingesta, por ejemplo, transformando datos sin procesar en series temporales y creando eventos empresariales a partir de líneas de registro.

- Contexto de datos completo: Enriquece y conserva el contexto de puntos de datos heterogéneos -incluidas métricas, trazas, logs, comportamiento de usuarios, vulnerabilidades, amenazas y otros- que reflejan las diversas partes del ecosistema cloud donde se originaron.

- Controles para la privacidad y seguridad de los datos: Ofrece a los usuarios el control sobre los datos que analizan, almacenan o excluyen de los análisis e incluye controles de seguridad y privacidad totalmente personalizables, como el enmascaramiento automático y basado en funciones PII para ayudar a satisfacer las necesidades específicas y los requisitos de los clientes.

- Gestión de datos rentable: Ayuda a los equipos a evitar la ingesta de datos duplicados y reduce las necesidades de almacenamiento transformando los datos en formatos utilizables y permitiendo a los equipos eliminar los campos innecesarios sin perder ninguna información, contexto o flexibilidad de análisis.