El auge del vibe coding dispara nuevas amenazas

- Vulnerabilidades

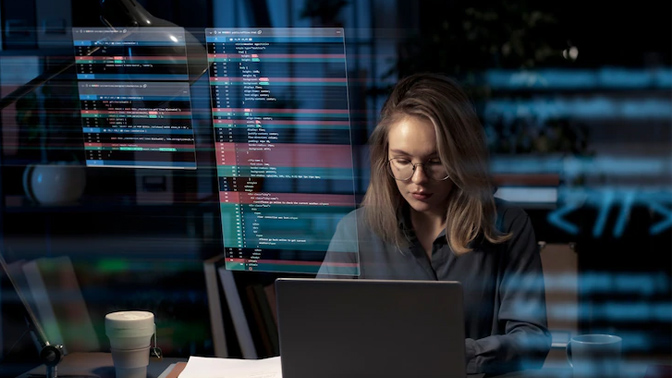

La adopción masiva de herramientas de codificación asistida por inteligencia artificial está transformando el desarrollo de software, pero también multiplicando los riesgos de seguridad. El vibe coding puede generar fallos críticos que pasan inadvertidos hasta llegar a producción.

La codificación asistida por inteligencia artificial, conocida como vibe coding, se ha convertido en una práctica habitual en los equipos de desarrollo. Según el State of Cloud Security Report 2025 de Palo Alto Networks, el 99% de las organizaciones ya emplea agentes de IA para generar código, automatizar tareas y acelerar ciclos de entrega.

Estas herramientas permiten a desarrolladores profesionales, y también a desarrolladores ciudadanos sin conocimientos avanzados en seguridad, producir grandes volúmenes de código funcional en muy poco tiempo. Sin embargo, esta velocidad tiene un coste, ya que el código generado puede contener vulnerabilidades ocultas, malas prácticas o dependencias inseguras que no se detectan en las pruebas iniciales y emergen cuando la aplicación ya está en producción.

El problema no es la tecnología en sí, sino la confianza excesiva en el código generado por IA. El vibe coding suele producir fragmentos que “parecen correctos” y funcionan, pero no están diseñados para cumplir estándares de secure coding.

El análisis destaca que muchas vulnerabilidades actuales nacen directamente en la fase de desarrollo, donde la IA genera código a gran velocidad, aumentando la probabilidad de introducir fallos como desarrollo inseguro que deriva en brechas de seguridad, lógica vulnerable que permite ejecución de código, mecanismos débiles que facilitan eludir la autenticación, y eliminación accidental de bases de datos y pérdida de información.

Además, estas herramientas se han convertido en un nuevo objetivo para los ciberdelincuentes, que buscan manipular su comportamiento mediante inyección de instrucciones, o introduciendo fragmentos de código malicioso procedentes de repositorios externos.

Del desarrollo asistido al riesgo automatizado

Unit 42 advierte que la automatización sin supervisión puede generar un efecto dominó: errores pequeños que se propagan rápidamente a múltiples módulos, servicios o microservicios. La IA acelera la creación de software, pero también acelera la propagación de fallos, especialmente cuando los equipos confían en exceso en el resultado generado.

Para mitigar estos riesgos y garantizar que la IA se utilice de forma segura en el ciclo de vida del software se recomienda integrar requisitos de seguridad desde el inicio del desarrollo asistido por IA; revisar sistemáticamente el código generado, incluso si parece correcto; combinar controles automatizados con validaciones humanas especializadas; monitorizar el comportamiento de los agentes de IA para detectar manipulaciones o desviaciones; y verificar la procedencia y seguridad de dependencias externas.